Introduction

La mesure a toujours été un élément essentiel de l'agriculture. Les agriculteurs mesurent le rendement de leurs cultures en boisseaux, en sacs ou en paniers. Sans mesure, ils ne peuvent ni planifier, ni commercialiser leurs produits, ni gagner leur vie. Après de nombreuses années d'essais et d'erreurs, les auteurs ont compris que la mesure est tout aussi indispensable dans le développement agricole.

Plant With Purpose (plantwithpurpose.org) est un partenariat chrétien à but non lucratif qui œuvre à l'échelle mondiale auprès des petits exploitants agricoles pour relever les défis économiques, environnementaux et spirituels. La mesure de l'impact est au cœur de notre travail et nous cherchons continuellement à améliorer nos méthodes. Chez Plant With Purpose, l'évaluation, le suivi et l'apprentissage ne sont pas des compléments aux programmes— ils en sont les éléments fondamentaux. Ces fonctions orientent les décisions en temps réel, nous aident à comprendre ce qui est efficace ou non, renforcent l’impact à long terme et garantissent la redevabilité envers les communautés que nous servons, ainsi qu’envers nos donateurs et partenaires. Le budget alloué à ces efforts n'est ni discrétionnaire ni facultatif ; il constitue un investissement essentiel dans l'intégrité, l'efficacité et l'amélioration continue de notre mission. Saper cet investissement reviendrait à compromettre la qualité et la crédibilité du travail lui-même. Dans cet article, nous partageons une méthode que nous utilisons pour mesurer l'impact des programmes : la méthode des doubles différences.

Qu'est-ce que la méthode des doubles différences?

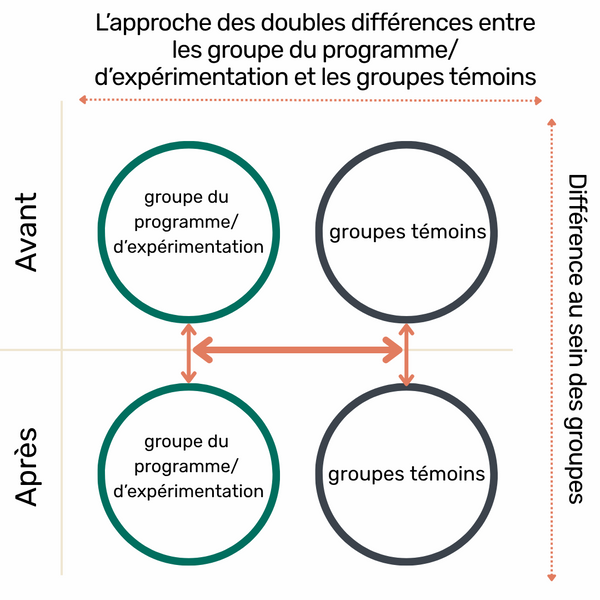

Figure 14. Explication visuelle de la méthode des différences en différences. Source: adapté de la FAO, 2008.

La méthode des doubles différences (ou diff-in-diff, ou DID ; figure 14) est une amélioration majeure apportée à nos pratiques de mesure ces dernières années. Auparavant, nous mesurions l'impact de nos travaux en comparant deux groupes d'échantillons : des participants au programme et des non-participants, sélectionnés aléatoirement dans les communautés de la zone d'intervention. Cette conception, souvent qualifiée de « naïve » (Newcomer et al. , 2015), permettait de déterminer s'il existait une différence entre les groupes d'échantillons, mais ne permettait pas de savoir si cette différence était due au programme lui-même ou à d'autres facteurs.

Le biais de sélection constitue une limite majeure de cette conception. Les participants peuvent sembler mieux lotis simplement parce qu'ils étaient plus motivés, mieux connectés ou plus stables économiquement au départ. Sans tenir compte de ce biais, il est facile de surestimer l'impact réel d'un programme.

Les enquêtes de référence et de fin de projet, menées sans contrefactuel 5 pertinent, sont courantes, en partie à cause de contraintes telles que des budgets limités, un manque de personnel ou de capacités techniques. Cependant, l'atout de l'approche DiD réside dans le fait qu’elle offre une méthode rigoureuse et relativement accessible pour approximer un contrefactuel. En suivant l’évolution dans le temps à la fois (et non seulement la différence entre) les groupes de participants et de comparaison — idéalement issus de communautés appariées ou similaires — nous sommes mieux à même d’isoler l’effet du programme des tendances générales, des chocs locaux ou des différences préexistantes.

Nous considérons que ce passage vers l’intégration crédible et réalisable d’un contrefactuel ne constitue pas seulement une amélioration technique. C’est aussi un changement d’état d’esprit, qui traduit un engagement plus profond envers l’honnêteté dans l’évaluation de ce qui fonctionne réellement. Cela garantit que les affirmations d’impact reposent sur des fondements plus solides que la simple intention ou la corrélation.

Avantages de l’approche DiD

L’utilisation d’une approche DiD pour l’échantillonnage nous a aidé à améliorer notre travail de plusieurs manières :

Une meilleure compréhension des changements au fil du temps : Avec la conception simplifiée utilisée précédemment, nous pouvions mesurer les différences entre les groupes, mais nous ne pouvions pas déterminer si ces différences étaient dues à des changements réels au fil du temps ou directement liées au programme. L’approche DiD permet de clarifier quand et où les changements se produisent réellement.

Une meilleure compréhension des effets d'entraînement : Grâce à l'approche DiD, nous pouvons distinguer l'influence des participants sur les non-participants au sein d'une même communauté. Les agriculteurs participants partagent souvent des connaissances, des ressources ou des pratiques qui ont un impact positif sur leurs voisins. En incluant un groupe extérieur à la zone du programme, nous sommes mieux à même d'identifier et de mesurer ce type d'impact indirect. Par conséquent, nous avons constaté que les conceptions précédentes pouvaient avoir sous-estimé l'effet global du programme.

Une crédibilité accrue auprès des partenaires et des soutiens : À mesure que les donateurs et le grand public deviennent plus informés et plus exigeants, l'importance de justifier les déclarations d'impact par des preuves solides est de plus en plus importante. Cette évolution positive est en phase avec nos propres valeurs. Une conception DiD nous permet de respecter cette norme avec confiance et clarté. Elle améliore la transparence, renforce la confiance et positionne notre programme comme un engagement envers l'apprentissage et l'amélioration continus.

Des preuves en temps réel de l’impact de la mission : l’approche DiD fournit des preuves opportunes et crédibles de la capacité de nos programmes à atteindre les résultats escomptés, nous permettant ainsi de procéder à des ajustements éclairés et de maintenir notre travail focalisé et aligné sur notre mission.

Les défis de l’approche DiD

Complexité logistique : Un modèle fondé sur l’approche DiD nécessite l'identification de deux zones d'échantillonnage distinctes : une zone d’expérimentation où le programme est mis en œuvre et une zone témoin où il ne l'est pas. Alors que la réalisation d'évaluations dans la zone d’expérimentation peut déjà s'avérer complexe, le travail dans la zone témoin introduit souvent une complexité encore plus grande. Les communautés non impliquées dans le programme peuvent ne pas connaître notre travail et, naturellement, être plus réticentes à participer aux activités de collecte de données.

Intensité des ressources : La mise en œuvre d'une évaluation selon l’approche DiD requiert davantage de ressources que les modèles plus simples. Comme elle implique la collecte de données sur deux sites différents et à deux moments précis (avant et après), le coût global et les exigences de coordination sont nettement plus élevés. Cet investissement est significatif, mais exige une planification et un engagement rigoureux.

Considérations éthiques : Étudier des communautés où le programme n’a pas encore été mis en place présente des défis éthiques particuliers. Contrairement à l’enquête auprès de non-participants dans une zone de programme active, travailler dans des communautés témoins peut soulever des inquiétudes quant à l’équité et à la transparence. Pour y remédier, nous sélectionnons des zones témoins approuvées et identifiées comme de solides candidates pour de futurs programmes. Cette approche respecte non seulement la dignité et les attentes de ces communautés, mais améliore également la comparabilité des données, car ces zones partagent des caractéristiques similaires à celles actuellement desservies.

Alternatives à l’approche DiD

Si les essais contrôlés randomisés (ECR) sont depuis longtemps considérés comme la référence absolue pour établir un impact causal (Banerjee et Duflo, 2011 ; Glennerster et Takavarasha, 2013), ils sont souvent coûteux, peu pratiques et éthiquement complexes dans des environnements dynamiques et communautaires. Les interventions communautaires efficaces sont souvent holistiques, inclusives et conçues pour évoluer avec la participation de la communauté— ce qui rend la randomisation rigide à la fois difficile et potentiellement perturbatrice. Les ECR nécessitent souvent une séparation artificielle entre les groupes d’expérimentation et les groupes témoins, ce qui peut être peu pratique ou éthiquement inapproprié dans des contextes de développement communautaire. L’approche DiD, en revanche, nous permet de suivre les changements au fil du temps au sein de groupes naturels. Cela fait de l’approche DiD une mesure d'impact plus adaptée dans des contextes où l'appropriation communautaire, les pratiques adaptatives et le changement à long terme sont au cœur de ce que nous considérons comme une réussite.

Comment mettre en œuvre une évaluation basée sur l’approche DiD

Il existe de nombreuses excellentes ressources sur la méthodologie DiD et les approches d'évaluation plus larges (Newcomer et al. , 2015 ; Gertler et al. , 2016). Les lignes directrices suivantes ont été élaborées par Plant With Purpose à partir de notre expérience dans la conduite d'études DiD en milieu communautaire et réel.

- Déterminer pourquoi, quoi et comment vous souhaitez mesurer : Avant de commencer une étude DiD, il est essentiel de définir pourquoi vous mesurez, ce que vous mesurez et comment vous prévoyez de le faire. Déterminer si l'objectif est d'améliorer la conception du programme, de répondre aux exigences des donateurs ou de suivre les progrès par rapport à un plan stratégique. Identifier les indicateurs que vous utiliserez et les méthodes les plus adaptées pour les saisir (enquêtes auprès des ménages, entretiens, ateliers participatifs, études de cas ou cartographie). Cette étape peut également aider à déterminer si l’approche DiD est la solution idéale. Si tel est le cas, les étapes suivantes vous fourniront des conseils pratiques.

- Outils d'évaluation de la conception : Les enquêtes auprès des ménages sont courantes dans les études DiD, mais d'autres méthodes, telles que les ateliers participatifs ou la collecte de données spatiales,6

6 Pour des exemples d'ateliers participatifs, voir Flanangan (2015). Les données spatiales comprennent notamment les caractéristiques physiques et environnementales d'une zone géographique.peuvent également être utilisées. Quelle que soit la méthode choisie, les outils doivent être conformes aux objectifs fixés à l'étape 1. Lors de l'utilisation d'enquêtes auprès des ménages, une conception réfléchie des questions est particulièrement importante. Plusieurs ressources fournissent des conseils sur la conception de questions efficaces (Bradburn et al. , 2004). Pour les enquêtes nécessitant une traduction, traduire et rétro-traduire le contenu pour garantir sa clarté. Tester les versions finales avant la mise en œuvre complète. Nous recommandons l'utilisation d'outils de collecte de données numériques. Les plateformes numériques améliorent la qualité des données, réduisent les coûts et minimisent les erreurs par rapport aux outils en version papier.

- Identifier une zone témoin et une zone d’expérimentation : La zone témoin doit être aussi similaire que possible à la zone d’expérimentation en termes de population, de géographie et d'économie locale. Les correspondances parfaites sont rares. Nous avons constaté que la proximité géographique constitue souvent un indicateur raisonnable de similarité et constitue une approche pratique.

- Déterminer la taille de l'échantillon : Si vous utilisez des enquêtes auprès des ménages, appliquez des méthodes statistiques pour calculer la taille d'échantillon requise. Cela dépendra de la précision requise et de l'ampleur de l'effet attendu. De nombreux outils sont disponibles pour faciliter cette étape, comme le « Calculateur de taille d'échantillon » (2025).

- Échantillonnage aléatoire : L’échantillonnage aléatoire des ménages réduit le risque de biais dans une enquête auprès des ménages ; c’est aussi l’une des étapes les plus complexes du processus DiD. Pour réduire la charge de travail et les coûts, nous utilisons une approche d’échantillonnage en grappes. Répertoriez toutes les communautés de la zone d’échantillonnage. Sélectionnez aléatoirement une partie de ces communautés et collectez les listes des ménages de ces communautés. L’équipe du programme travaille avec les responsables communautaires pour créer les listes des ménages. Utilisez ces listes pour sélectionner aléatoirement les ménages à échantillonner dans l’enquête. Ce processus prend généralement plusieurs semaines, voire plusieurs mois, et doit commencer avant le calendrier prévu pour l’enquête.

- Identifier et former l'équipe d'enquêteurs ou d'agents recenseurs:7

7Les recenseurs collectent, compilent et synthétisent les données recueillies au moyen d’enquêtes ou de recherches sur le terrain au sein des communautés.Les enquêteurs doivent être formés par une personne familiarisée avec la conception de l'outil. Cette formation doit avoir lieu peu avant le début des travaux de terrain. Les agents recenseurs doivent maîtriser les langues locales, comprendre les outils d'enquête et ne pas être directement impliqués dans le programme. Pour les outils participatifs, une équipe d'animation distincte peut nécessiter sa propre formation.

- Tester la qualité de l'enquête : Les équipes d'enquête doivent s'entraîner avant le déploiement complet. Prévoir du temps pour les questions et les retours d’expériences. Ensuite, réaliser un test sur le terrain pour vérifier la compréhension et la cohérence.

- Surveiller la qualité des données pendant la collecte : Dans la mesure du possible, suivre la qualité des données en temps réel. Les outils numériques facilitent cette tâche. En cas de problème, informer immédiatement l'équipe afin qu'elle puisse apporter des corrections sur le terrain.

- Nettoyer les données : Une fois les données collectées, les examiner attentivement. Si la collecte numérique réduit de nombreuses erreurs courantes, tous les jeux de données nécessitent un certain niveau de nettoyage.

- Analyser les données : Utiliser les indicateurs et les questions décrits à l’étape 1 pour guider votre analyse. Cela peut inclure des statistiques descriptives de base ou des comparaisons entre groupes. Nous effectuons nos analyses à l’aide de la plateforme statistique R(R Core Team, 2024), et d’outils conviviaux comme RStudio (Posit, 2025).

- Partager les résultats avec les parties prenantes : Une fois les données analysées, partager les résultats avec les parties prenantes, notamment les membres de la communauté et les équipes de programme. Le partage et la sollicitation de retours permettent de valider les résultats et de fournir un contexte important.

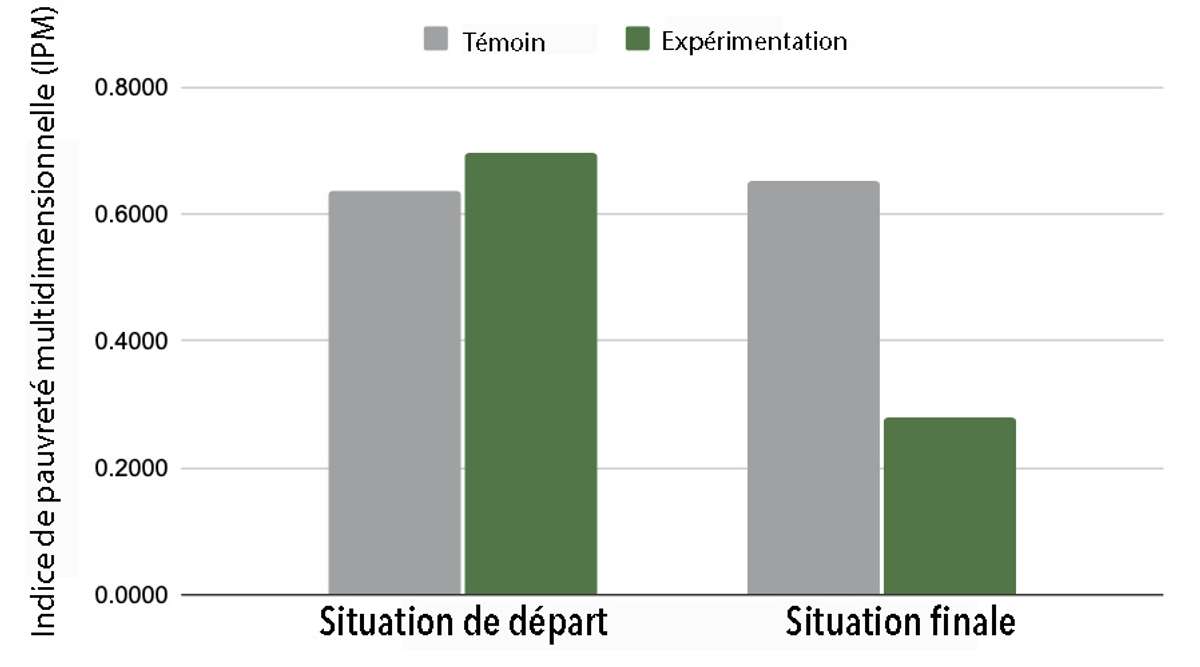

- Préparer et diffuser un rapport final : Une communication efficace est essentielle. Préparez un rapport final utile et compréhensible pour différents publics, y compris les communautés, les bailleurs de fonds et le personnel interne. Une communication solide garantit que les résultats sont appliqués et crédibles. La Figure 15 présente un exemple de visualisation des résultats DiD issus des programmes de Plant With Purpose en RDC.

Figure 15. Résultats de l’analyse DiD du programme Plant With Purpose en RDC. Les diagrammes à barres montrent l’évolution de l’Indice de Pauvreté Multidimensionnelle (IPM) entre la situation de départ et la situation finale, pour un bassin versant d’expérimentation et un bassin versant témoin.

- Répétez l'opération pour les études de suivi : Si vous réalisez une étude intermédiaire ou finale, répétez les Étapes 6 à 12. La cohérence entre les différentes périodes de collecte est essentielle pour garantir la précision des calculs DiD.

- Effectuer l'analyse DiD : Une fois les données de référence et de suivi collectées, calculez la DiD en utilisant la formule suivante (GitHub, 2025) :

DID = (T1-T0) - (C1-C0)

Où:

- T1 est la valeur dans la zone d’expérimentation après l'intervention

- T0 est la valeur dans la zone d’expérimentation avant l'intervention

- C1 est la valeur dans la zone témoin après l'intervention

- C0 est la valeur dans la zone témoin avant l'intervention

Par exemple, si l’indicateur est le pourcentage de ménages appliquant des engrais verts :

| Témoin | Expérimentation | |

|---|---|---|

| Avant | 20% | 15% |

| Après | 22% | 40% |

La double différence pour l’application d’engrais vert serait alors la suivante :

(40-15) - (22-20) = 25 - 2 = 23

Ce qui signifie que le taux d’application d'engrais verts a augmenté dans la zone témoin (de 2 %) et dans la zone d’expérimentation (de 25 %), mais que la variation de la zone d’expérimentation par rapport à la zone de témoin est de 23 %. Si la taille de votre échantillon est suffisante, vous pouvez valider le résultat par un test de signification statistique (par exemple, un test T ; ScienceDirect, 2020 ; Torres-Reyna, 2015).

Conclusion

La mesure a toujours joué un rôle central dans l’agriculture — et elle est tout aussi essentielle dans le développement agricole. Pour nous, l’adoption d’un modèle d’étude fondé sur la méthode des doubles différences (DiD) a renforcé notre capacité à détecter les changements dans le temps et à évaluer si ces changements sont susceptibles d’être le résultat des activités du programme.

Bien que l’approche DiD soit plus complexe et plus exigeante en ressources que des modèles d’évaluation plus simples, l’investissement s’est révélé bénéfique. Elle nous a permis d’obtenir des analyses plus claires, des preuves plus solides et une plus grande confiance dans l’efficacité de notre travail. Pour les organisations axées sur l’apprentissage et la redevabilité, cette approche offre un moyen pratique de mieux comprendre l’impact.

Références

Banerjee, A.V. et E. Duflo. 2011. Poor Economics: A radical rethinking of the way to fight global poverty [L’économie des pauvres : repenser radicalement la lutte contre la pauvreté dans le monde]. Public Affairs.

Bradburn, N.M., S. Sudman, et B. Wansink. 2004. Asking Questions: The Definitive Guide to Questionnaire Design–for Market Research, Political Polls, and Social and Health Questionnaires [Poser les bonnes questions : le guide définitif de la conception de questionnaires – pour les études de marché, les sondages politiques et les enquêtes sociales et sanitaires]. John Wiley & Sons.

FAO. 2008. Série sur l'évaluation de l'impact. Document d'orientation de la FAO. FAO Guidance Document.

Flanagan, B. 2015. Méthodes et outils participatifs dans le développement communautaire. Résumé par ECHO des documents de méthodes participatives de MEAS.

Gertler, P.J., S. Martinez,P. Premand, L.B. Rawlings, C.M.J. et Veermersch. 2016. “Impact Evaluation in Practice - Second Edition [Évaluation d'impact en pratique – Deuxième édition]. Texte/HTML. Banque mondiale].” Text/HTML. World Bank. https://www.worldbank.org/en/programs/sief-trust-fund/publication/impact-evaluation-in-practice.

GitHub, 2025. Difference-in-difference. https://ds4ps.org/pe4ps-textbook/docs/p-030-diff-in-diff.html

Glennerster, R., et K. Takavarasha. 2013. Running randomized evaluations: A practical guide [Exécution d'évaluations randomisées : Guide pratique]]. Princeton University Press. https://doi.org/10.2307/j.ctt4cgd52.

Newcomer, K., H. Hatry, H, et J. Wholey. 2015. Handbook of Practical Program Evaluation [Manuel d'évaluation pratique des programmes] , 4e édition | Wiley. https://www.wiley.com/en-ca/

Posit. 2025.« RStudio. » Posit (blog). 2025. https://www.posit.co/.

R Core Team. 2024. “R: The R Project for Statistical Computing ” [R : Le projet R pour le calcul statistique].” 2024. https://www.r-project.org/.

“Sample Size Calculator.” 2025. https://www.calculator.net/sample-size-calculator.html.

ScienceDirect. 2020. “Difference-In-Differences - an overview ” [L’approche des doubles différences – Aperçu] | ScienceDirect Topics.” https://www.sciencedirect.com/topics/economics-econometrics-and-finance/difference-in-differences.

Torres-Reyna, O. 2015. “Difference in Differences (v3.3) [L’approche des doubles différences (v3.3)].” Princeton U. https://princeton.edu/~otorres/DID101.pdf.