Introducción

La medición siempre ha sido una parte vital de la agricultura. Los productores miden el rendimiento de sus cultivos por medio de fanegas, quintales, sacos o canastas. Sin mediciones, no pueden planificar, comercializar sus productos o ganarse la vida. Tras muchos años de ensayo y error, los autores han llegado a comprender que la medición es esencial en el desarrollo agrícola.

Plant With Purpose (plantwithpurpose.org) es una asociación cristiana sin fines de lucro que trabaja a escala mundial con pequeños productores para ocuparse de los desafíos económicos, ambientales y espirituales. Medir el impacto es vital para nuestro trabajo, y trabajamos en forma continua para mejorar nuestros métodos. En Plant With Purpose la evaluación, el monitoreo y el aprendizaje no son complementos de la programación, sino que son elementos fundamentales. Estas funciones guían las decisiones en tiempo real, nos ayudan a entender qué es efectivo y qué no lo es, fortalecen el impacto a largo plazo y garantizan la rendición de cuentas ante las comunidades a las que servimos, así como ante nuestros donantes y socios. El presupuesto para estos esfuerzos no es discrecional u opcional; es una inversión central en la integridad, la eficacia y la mejora continua de nuestra misión. Socavar esta inversión significaría debilitar la calidad y la credibilidad del trabajo en sí En este artículo, compartimos un método que utilizamos para medir el impacto del programa —Diferencias en Diferencias.

¿Qué es Diferencias en Diferencias?

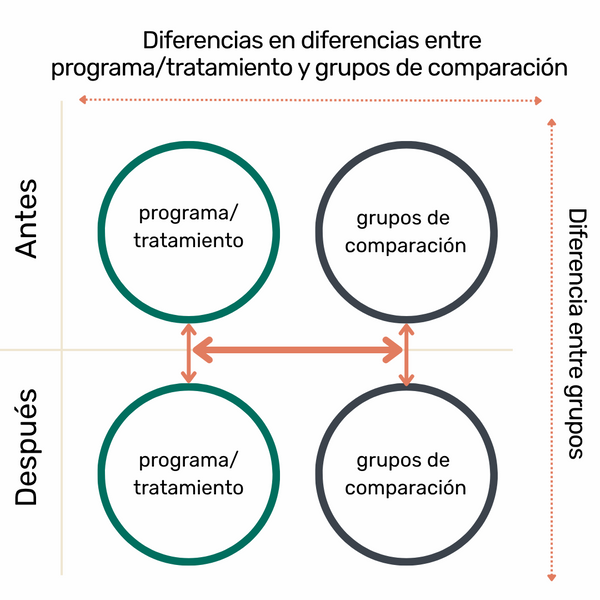

Figura 14. Explicación visual de la Diferencia en Diferencias. Fuente: adaptado de la FAO, 2008.

Diferencias en diferencias (o diff-in-diff, o DID por sus siglas en inglés; Figura 14) es una mejora clave que hemos hecho a nuestras prácticas de medición en los últimos años. Anteriormente, medíamos el impacto de nuestro trabajo al comparar dos grupos de muestra: participantes en el programa y no participantes, seleccionados aleatoriamente de comunidades dentro del área del programa. Este diseño, a menudo referido como un diseño “ingenuo” (Newcomer et al., 2015), podría mostrar si había una diferencia entre los grupos muestra, pero no podía decirnos si esa diferencia había sido realmente causada por el propio programa o por otros factores.

El sesgo de selección es una limitación importante de ese diseño. Para comenzar, los participantes pueden parecer estar en mejor situación simplemente porque estaban más motivados, mejor conectados o económicamente más estables. Sin tener esto en cuenta, es fácil exagerar el verdadero impacto de un programa.

Las encuestas de línea base y de línea final sin un elemento contrafactual 5 significativo son comunes, en parte debido a consideraciones como presupuestos limitados, la dotación de personal o capacidad técnica. Sin embargo, la fortaleza de un enfoque DID es que proporciona una forma rigurosa y relativamente accesible de aproximarse a un elemento contrafactual. Al darle seguimiento a los cambios a lo largo del tiempo tanto en el participante (en lugar de solo entre) y los grupos de comparación, idealmente en comunidades acompañantes o similares, podemos aislar mejor el efecto del programa de las tendencias generales, los choques locales o las diferencias preexistentes.

Creemos que este cambio hacia la incorporación creíble y factible de un elemento contrafactual, no es solo una mejora técnica. Es un cambio de mentalidad, que refleja un compromiso más profundo con la sinceridad sobre lo que está funcionando. Garantiza que las afirmaciones sobre el impacto se basen en algo más fuerte que la intención o la correlación por sí sola.

Beneficios del enfoque DID

La utilización del enfoque DID para el muestreo nos ha ayudado a mejorar nuestro trabajo de varias formas:

Mejor comprensión del cambio a lo largo del tiempo: en el diseño más simple que utilizamos anteriormente, pudimos medir las diferencias entre los grupos, pero no pudimos determinar si esas diferencias se debían a cambios reales a lo largo del tiempo o estaban directamente relacionadas con el programa. El enfoque DID ayuda a aclarar cuándo y dónde se está produciendo realmente el cambio.

Una visión más clara de los efectos secundarios: con el enfoque DID, podemos separar la influencia de los participantes sobre los no participantes dentro de la misma comunidad. Los productores participantes a menudo comparten conocimientos, recursos o prácticas que afectan positivamente a sus vecinos. Al incluir un grupo —fuera del área del programa— podemos identificar y medir mejor este tipo de impacto indirecto. Como resultado, hemos encontrado que los diseños anteriores pueden haber subestimado el efecto general del programa.

Mayor credibilidad ante los socios y aliados: a medida que los donantes y el público en general se vuelven más informados y exigentes, hay un énfasis creciente en fundamentar las afirmaciones sobre el impacto logrado con evidencia sólida. Este desarrollo positivo armoniza con nuestros propios valores. Un diseño DID nos permite cumplir esta norma con confianza y claridad. Refuerza la transparencia, fortalece la confianza y posiciona nuestro programa como comprometido con el aprendizaje continuo y el mejoramiento.

Evidencia en tiempo real del impacto de la misión: el enfoque DID produce evidencia oportuna y creíble de si nuestros programas logran los resultados previstos, lo que nos permite hacer ajustes informados y mantener nuestro trabajo enfocado y alineado con nuestra misión.

Desafíos del enfoque DID

Complejidad logística: Un diseño DID requiere la identificación de dos áreas de muestreo separadas, una área de tratamiento donde se implementa el programa y una área de comparación donde no se implementa. Si bien hacer evaluaciones en el área de tratamiento puede ser un desafío, trabajar en el área de comparación suele introduce una complejidad aún mayor. Las comunidades que no participan en el programa pueden no estar familiarizadas con nuestro trabajo y, comprensiblemente, menos dispuestas a participar en actividades de recopilación de datos.

Intensidad de recursos: implementar una evaluación DID demanda más recursos que diseños más sencillos. Debido a que implica la recopilación de datos en dos lugares diferentes y en dos puntos en el tiempo (antes y después), el costo general y las demandas de coordinación son considerablemente mayores. Esta inversión es significativa, pero requiere una planificación y un compromiso cuidadosos.

Consideraciones éticas: el estudio de comunidades donde aún no se ha introducido el programa plantea desafíos éticos únicos. A diferencia de encuestar a los no participantes dentro de un área activa del programa, trabajar en comunidades de comparación pueden generar preocupaciones sobre la equidad y la transparencia. Para ocuparse de esto, seleccionamos áreas de comparación verificadas que se han identificado como candidatos fuertes para programas en el futuro. Este enfoque no sólo respeta la dignidad y las expectativas de esas comunidades, sino que también mejora la comparabilidad de los datos, ya que estas áreas comparten características similares con las que actualmente se atienden.

Alternativas al enfoque DID

Si bien los ensayos controlados aleatorios (ECR) se han considerado durante mucho tiempo como la norma de oro para establecer el impacto causal (Banerjee y Duflo, 2011; Glennerster y Takavarasha, 2013), suelen ser costosos, poco prácticos y desafiantes desde el punto de vista ético en entornos dinámicos dirigidos por la comunidad. Las intervenciones comunitarias eficaces son a menudo holísticas, inclusivas y diseñadas para evolucionar con la participación de la comunidad, lo que hace la aleatoriedad rígida tanto difícil como potencialmente perjudicial. Los ECR a menudo requieren una separación artificial entre los grupos de tratamiento y de control, lo que puede resultar poco práctico o inadecuado desde el punto de vista ético en contextos de desarrollo comunitario. El enfoque DID, por el contrario, nos permite dar seguimiento a los cambios a lo largo del tiempo dentro de grupos naturales. Esto hace que este enfoque sea más adecuado para medir el impacto en escenarios donde el empoderamiento de la comunidad, las prácticas adaptativas y el cambio a largo plazo son fundamentales para lo que consideramos éxito.

Cómo ejecutar una evaluación utilizando el enfoque DID

Existen disponibles muchos excelentes recursos sobre la metodología DID y enfoques de evaluación más amplios (Newcomer et al., 2015; Gertler et al., 2016). Las siguientes son directrices que Plant With Purpose desarrolló sobre la base de nuestra experiencia en la realización de estudios DID en contextos comunitarios del mundo real.

- Determine por qué, qué y cómo desea medir: antes de comenzar un estudio DID, es esencial definir por qué está midiendo, lo que está midiendo y cómo planea medirlo. Considere si el objetivo es mejorar el diseño del programa, cumplir con los requisitos de los donantes o dar seguimiento del avance en relación con un plan estratégico. Identifique los indicadores que utilizará y los métodos más adecuados para captarlos (encuestas de hogares, entrevistas, talleres participativos, estudios de casos o mapeo). Este paso también puede ayudar a determinar si el enfoque DID es el adecuado. En caso afirmativo, los siguientes pasos ofrecen orientación práctica.

- Diseñar herramientas de evaluación: las encuestas de hogares son comunes en los estudios DID, pero también se pueden utilizar otros métodos, como los talleres participativos o la recopilación de datos espaciales.6

6Para ver ejemplos de talleres participativos, consulte Flanangan (2015). Entre los ejemplos de datos espaciales se incluyen las características físicas/medioambientales de una zona geográfica.Cualquiera que sea el método elegido, las herramientas deben alinearse con los objetivos establecidos en el Paso 1. Al usar encuestas de hogares, es especialmente importante formular preguntas basadas en la reflexión. Varios recursos ofrecen orientación sobre cómo diseñar preguntas eficaces (Bradburn et al., 2004). Para las encuestas que requieren traducción, hacer también la traducción inversa del contenido para garantizar la claridad. Poner a prueba en forma de piloto los borradores finales antes de la implementación plena.Recomendamos el uso de herramientas digitales para la recopilación de datos. Las plataformas digitales mejoran la calidad de los datos, reducen los costos y minimizan los errores en comparación con las herramientas basadas en papel.

- Identificar una zona de comparación y una zona de tratamiento: la zona de comparación debe ser lo más similar posible a la zona de tratamiento en términos de población, geografía y economía local. Las coincidencias perfectas son raras. Hemos encontrado que la proximidad geográfica a menudo sirve como un indicador razonable para la similitud y hace que sea un enfoque práctico.

- Determinar el tamaño de la muestra: si se utilizan encuestas de hogares, aplicar métodos estadísticos para calcular el tamaño de la muestra requerido. Esto dependerá de la precisión necesaria y del tamaño del efecto esperado. Muchas herramientas están disponibles para apoyar este paso, como la “Sample Size Calculator [Calculadora de tamaño de muestra]” (2025).

- Tomar una muestra aleatoria: la toma de muestras aleatorias de los hogares reduce el riesgo de sesgo en una encuesta familiar; también es uno de los pasos más difíciles del proceso DID. Para reducir la cantidad de trabajo y el costo, utilizamos un enfoque de muestreo por conglomerados. Enumere todas las comunidades en la zona de la muestra. Seleccione aleatoriamente una parte de estas comunidades y recopile listas de hogares de estas comunidades seleccionadas. El personal del programa trabaja con los líderes comunitarios para crear listas de hogares. Utilizar estas listas para seleccionar al azar los hogares a muestrear en la encuesta. Este proceso suele durar varias semanas o meses y debe comenzar antes del calendario previsto de la encuesta.

- Identificar y formar al equipo encuestador7:

7Los encuestadores recogen, compilan y sintetizan datos a través de encuestas o investigaciones sobre el terreno dentro de las comunidades.los encuestadores deben ser capacitados por alguien familiarizado con el diseño de la herramienta. La capacitación debería hacerse poco antes del inicio del trabajo en el terreno. Los encuestadores deben hablar con fluidez los idiomas locales, comprender las herramientas de la encuesta y no participar directamente en el programa. En el caso de las herramientas participativas, un equipo de facilitación separado puede necesitar su propia capacitación.

- Probar la calidad de las encuestas: los equipos encuestadores deben practicar antes del despliegue completo. Incluir tiempo para preguntas y retroalimentación. Siga esto con una prueba basada en el terreno para verificar la comprensión y consistencia.

- Monitorear la calidad de los datos durante la recopilación: siempre que sea posible, dar seguimiento a la calidad de los datos en tiempo real. Las herramientas digitales facilitan este proceso. Cuando surjan problemas, proporcione retroalimentación inmediata al equipo para que haga correcciones sobre el terreno.

- Limpiar los datos: una vez recogidos, analice a fondo el conjunto de datos. Si bien la recopilación digital reduce muchos errores comunes, todos los conjuntos de datos requieren un nivel de limpieza.

- Analizar los datos: utilice los indicadores y las preguntas descritas en el paso 1 para guiar su análisis. Esto podría incluir estadísticas descriptivas básicas o comparaciones entre grupos. Realizamos nuestros análisis utilizando la plataforma estadística R (R Core Team, 2024), y herramientas fáciles de usar como RStudio (Posit, 2025).

- Compartir los resultados con las partes interesadas: una vez que se hayan analizado los datos, compartir los resultados con las partes interesadas, incluidos los miembros de la comunidad y los equipos del programa. Compartir y solicitar retroalimentación ayuda a validar los hallazgos y proporciona un contexto importante.

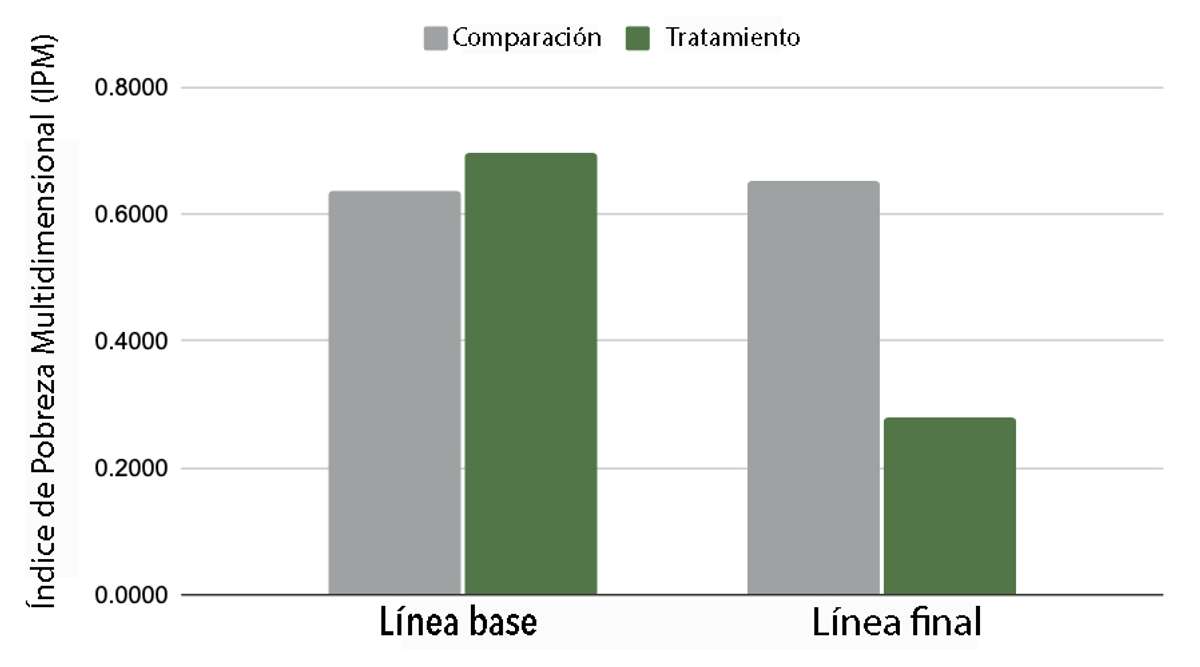

- Preparar y compartir un informe final: la presentación efectiva de informes importa. Preparar un informe final que sea útil y comprensible para las diferentes audiencias, incluidas las comunidades, los donantes y el personal interno. Una comunicación sólida garantiza la aplicación de los hallazgos y la confianza en ellos. La Figura 15 muestra un ejemplo de una visualización de los resultados DID de los programas de Plant With Purpose en la RDC.

Figura 15. Resultados DID del programa Plant With Purpose en la RDC. Los gráficos de barras muestran el cambio en el índice de pobreza multidimensional (IPM) desde la línea de base a la línea final, para una cuenca hidrográfica de tratamiento y la cuenca hidrográfica de comparación.

- Repetir para estudios de seguimiento: si está haciendo un estudio de línea media o final, repita los pasos 6 a 12. La consistencia entre los puntos de tiempo es clave para asegurar cálculos DID precisos.

- Realizar el análisis DID: una vez que se hayan recogido los datos de línea base y de seguimiento, calcular el DID utilizando la siguiente fórmula (GitHub, 2025):

DID = (T1-T0) - (C1-C0)

Donde:

- T1 es el valor en la zona de tratamiento después de la intervención

- T0 es el valor en la zona de tratamiento antes de la intervención

- C1 es el valor en la zona de comparación después de la intervención

- C0 es el valor en la zona de comparación antes de la intervención

Por ejemplo, si el indicador es el porcentaje de hogares que aplican abono verde:

| Comparación | Tratamiento | |

|---|---|---|

| Antes | 20% | 15% |

| Después | 22% | 40% |

Entonces la diferencia en las diferencias para la aplicación de abono verde sería,

(40-15) - (22-20) = 25 - 2 = 23

Lo que significa que la tasa de aplicación de abonos verdes aumentó tanto en la zona de comparación (2%) como en la zona de tratamiento (25%), pero el cambio del Tratamiento sobre la Comparación es un cambio del 23%. Si su tamaño de muestra es suficiente, puede validar el resultado con una prueba de significancia estadística (e.g. T-test; ScienceDirect, 2020; Torres-Reyna, 2015).

Conclusión

La medición siempre ha desempeñado un papel central en la agricultura y es igualmente vital para el desarrollo agrícola. Para nosotros, la adopción de un diseño de estudio de diferencias-en-diferencias (DID) ha fortalecido nuestra capacidad para detectar cambios a lo largo del tiempo y evaluar si ese cambio es probablemente el resultado de las actividades del programa.

Si bien el DID es más complejo y requiere más recursos que los diseños de evaluación más sencillos, la inversión ha merecido la pena. Ha proporcionado conocimientos más claros, evidencia más sólida y una mayor confianza en la eficacia de nuestro trabajo. Para las organizaciones centradas en el aprendizaje y la rendición de cuentas, este enfoque ofrece una forma práctica de comprender mejor el impacto.

Referencias

Banerjee, A.V. y E. Duflo. 2011. Poor Economics: A radical rethinking of the way to fight global poverty [un replanteamiento radical de la lucha contra la pobreza mundial]. Public Affairs.

Bradburn, N.M., S. Sudman, y B. Wansink. 2004. Asking Questions: The Definitive Guide to Questionnaire Design–for Market Research, Political Polls, and Social and Health Questionnaires [Hacer preguntas: la guía definitiva para el diseño de cuestionarios-para estudios de mercado, encuestas políticas y cuestionarios sociales y de salud]. John Wiley & Sons.

FAO. 2008. IPM Impact Assessment Series [Serie sobre evaluación de los efectos]. Documento de orientación de la FAO.

Flanagan, B. 2015. Participatory methods and tools in community development [Métodos y herramientas participativos en el desarrollo comunitario]. Resumen de ECHO de documentos sobre los métodos participativos MEAS.

Gertler, P.J., S. Martinez,P. Premand, L.B. Rawlings, C.M.J. y Veermersch. 2016. “Impact Evaluation in Practice - Second Edition [Evaluación del impacto en la práctica - Segunda edición].” Texto/HTML. Banco Mundial. https://www.worldbank.org/en/programs/sief-trust-fund/publication/impact-evaluation-in-practice.

GitHub, 2025. Difference-in-difference [Diferencias-en-Diferencias]. https://ds4ps.org/pe4ps-textbook/docs/p-030-diff-in-diff.html

Glennerster, R., y K. Takavarasha. 2013. Running randomized evaluations: A practical guide [Realización de evaluaciones aleatorias: una guía práctica]. Princeton University Press. https://doi.org/10.2307/j.ctt4cgd52.

Newcomer, K., H. Hatry, H, y J. Wholey. 2015. Handbook of Practical Program Evaluation, 4th Edition [Manual de evaluación práctica de programas, 4a Edición] | Wiley. https://www.wiley.com/en-ca/

Posit. 2025. “RStudio.” Posit (blog). 2025. https://www.posit.co/.

R Core Team. 2024. “R: The R Project for Statistical Computing [R: El proyecto R para la informática estadística].” 2024. https://www.r-project.org/.

“Sample Size Calculator [Calculadora de tamaño de muestra].” 2025. https://www.calculator.net/sample-size-calculator.html.

ScienceDirect. 2020. “Difference-In-Differences - an overview [Diferencia-en-diferencias - una visión general]| ScienceDirect Topics.” https://www.sciencedirect.com/topics/economics-econometrics-and-finance/difference-in-differences.

Torres-Reyna, O. 2015. “Difference in Differences (v3.3) [Diferencia-en-diferencias].” Princeton U. https://princeton.edu/~otorres/DID101.pdf.